Investigadores desarrollan un proyecto para detectar epidemias utilizando el monitoreo y análisis de textos periodísticos escritos en español. El trabajo tiene como principales desafios anotar un corpus de textos para validar y procesar los datos extraídos e implementar algoritmos que aprendan automáticamente de esos mismos datos. Este proceso de trabajo se convirtió en una reciente tesis de licenciatura.

Los sistemas de vigilancia epidemiológica consisten en estrategias consolidadas para detectar tempranamente la aparición o distribución de una enfermedad o infección y, a partir de ello, desarrollar programas de prevención, control o erradicación. Al mismo tiempo, realizar una evaluación sistemática de la situación epidemiológica permite identificar rápidamente en qué escenario se encuentra cada territorio para poder alertar y tomar decisiones en función de posibles cambios de escenario.

Dentro de estos sistemas, la recolección y análisis de datos de casos de las enfermedades es sumamente esencial. De este modo, existen dos tipos de sistemas, los formales o tradicionales que se basan en reportes oficiales de los sistemas u organismos de salud pública. Y los sistemas de vigilancia basados en eventos, que recolectan los datos a partir de fuentes no tradicionales tales como sitios de internet o artículos periodísticos, entre otras fuentes, información no tradicional que usualmente se genera más rápido que la información oficial. No obstante, el problema de procesar el enorme volumen de datos que circula y obtener información de valor para la toma de decisiones en políticas públicas está muy vigente, especialmente a partir del uso de técnicas de procesamiento del lenguaje natural que ayudan a clasificar esos datos.

Intentando enfrentar este problema, un proyecto de colaboración entre el ICC UBA-CONICET y la Universidad Católica San Pablo de Arequipa (UCSP), Perú, se propuso aplicar el análisis de textos periodísticos en español para la detección de enfermedades epidemiológicas presentes en Latinoamérica. “Previamente a la aparición del Covid-19 había muchos nombres de enfermedades endémicas que estaban surgiendo o circulando con más preponderancia. A partir de nuestro interés académico, observamos que -además de las fuentes oficiales- los epidemiólogos también utilizan fuentes no tradicionales para la vigilancia y al notar que se hablaba poco de esas enfermedades, encontramos una oportunidad no aprovechada para trabajar con el análisis de los datos provenientes de fuentes periodísticas”, puntualiza Viviana Cotik, Investigadora especializada en Procesamiento del Lenguaje Natural del ICC y Doctora en Ciencias de la Computación.

El proyecto comenzó hace más de tres años a partir de la convocatoria del investigador José Ochoa-Luna, profesor de inteligencia artificial de la UCSP. A partir de distintas fuentes, los investigadores decidieron usar ProMED-Mail, uno de los mayores sistemas de vigilancia en la web, que reúne artículos periodísticos de los medios masivos y los edita para poder aplicar filtros en distintos idiomas. “Seleccionamos y filtramos la información de ese sitio, tomando 1377 artículos en español y buscando palabras claves que tienen que ver con siete enfermedades endémicas en nuestra región: Dengue, Guillan-barré, Zika, Chagas, Sarampión, Hanta Virus y Microcefalia. Nuestro objetivo era saber cuántos casos de cada enfermedad había, ubicación geográfica donde ataca, a quiénes, causas y formas de transmisión, y en qué fechas exactamente ocurrió el brote de la enfermedad”, comenta Cotik.

No obstante, estructurar la información de los textos para poder representarla y visualizarla en un mapa, es una tarea muy compleja que usualmente requiere de un trabajo detallado de anotación de los textos y de la implementación de algoritmos para extraer la información de interés. Estos desafíos, propios del proyecto, convergieron en la Tesis de Licenciatura de Antonella Dellanzo “Detección de epidemias en textos periodísticos escritos en español”.

El desafío de anotación de los textos periodísticos

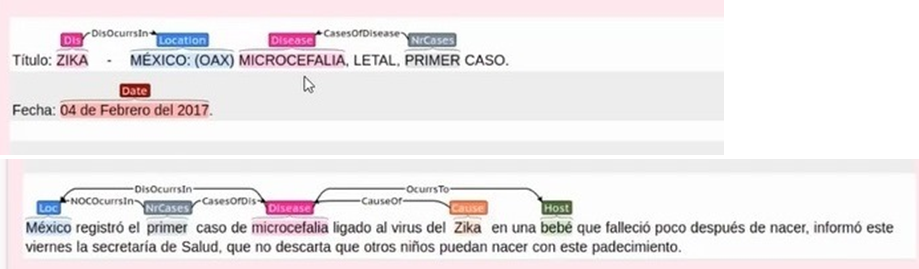

En lo que hace a tareas propias del procesamiento del lenguaje natural,los investigadores deben seleccionar un conjunto de textos a anotar y elaborar un criterio de anotación (teniendo en cuenta qué conceptos y relaciones entre esos conceptos son importantes). Una vez definidos los conceptos a anotar y criterios de anotación, la tarea de anotación del corpus de textos consiste en elaborar un documento con esos criterios, se capacita a los anotadores, los cuales anotan una porción de los datos, se evalúa cuán buena es esta anotación y, en función de esto, se hacen las correcciones al documento de criterios, realizando este ciclo varias veces con diferentes iteraciones, por lo que recién allí se hace la anotación definitiva.

(ejemplo de anotación). Fuente: Tesis de Dellanzo.

En este contexto, Cotik explica que, entre otras tareas, se trabajó en la limpieza de las notas periodísticas, eliminando la información no significativa de encabezados y pie de página, y quedándose solo con el título y cuerpo de la nota. También se realizó una normalización del contenido, para poder unificar la manera en que se menciona a las enfermedades y su contenido asociado (ya que el mismo contenido es nombrado de distinta forma en las notas).

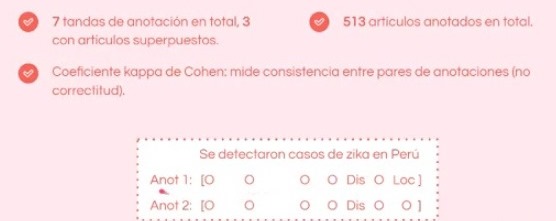

(anotación y evaluación). Fuente: Tesis de Dellanzo

(implementacion Kappa). Fuente: Tesis de Dellanzo

“Con un equipo de ocho personas, compuesto por cuatro estudiantes de la UCSP, una tesista, un lingüista y dos investigadores, realizamos el trabajo de anotación de los textos. Al no contar con financiamiento, nos llevó un poco más de un año realizar la anotación de ese subconjunto de textos, 513 artículos de los más de mil seleccionados. Además actualmente, según entendemos existen muy pocos corpus anotados en español”, detalla la investigadora. Y complementa: “Hay dos subtareas específicas de procesamiento del lenguaje natural (NLP), la primera es el reconocimiento de reconocimiento de entidades nombradas (NER) donde extraemos los fragmentos de texto que contienen nombres de enfermedades, ubicación, fecha de aparición, cantidad de casos, etc. y se clasifican en categorías preestablecidas. La segunda tarea consiste en la detección de relaciones entre dos o tres entidades nombradas, no sólo la aparición de la enfermedad sino relacionar dónde ocurrió o a cuántas personas afectó. De este modo, se puede extraer valor de los datos”. El complejo trabajo de anotación de los textos derivó en la publicación del paper «A Corpus for Outbreak Detection of Diseases Prevalent in Latin America» (2020).

¿Cómo son los algoritmos propios de esta tarea de procesamiento? El primer tipo de algoritmos está basado en reglas (por ej. para detectar la cantidad de casos de una enfermedad no se consideran números que puedan hacer referencia a porcentajes o a fechas y se busca que los números detectados estén en la proximidad de ciertas palabras clave), mientras que el segundo tipo de algoritmos tiene que ver con el uso de redes neuronales profundas, para que los propios algoritmos aprendan a partir de los datos . Cotik afirma que se necesita el apoyo de expertos, incluso en lingüística, para definir los criterios y que se entienda cuáles son las enfermedades de interés, qué partes del texto hacen referencia a cómo se transmiten, y a cuáles son sus causas, etc. ya que esos datos son los que se usarán para entrenar y evaluar al algoritmo de aprendizaje automático. “Es un trabajo muy arduo, la información anotada debe tomarse como valedera, es importante intentar evitar contar con una colección con datos sesgados. Nosotros armamos un documento de base, capacitamos a los anotadores, redefinimos criterios a partir del desarrollo de las anotaciones y recién ahí se lanzó el documento final que los anotadores utilizaron para realizar la anotación definitiva”, sostiene la investigadora en IA.

Próximos desafíos

En cuanto al trabajo a futuro la investigadora del ICC aclara que, entre otros, sería interesante mejorar y ampliar las anotaciones y poder mostrar los resultados en un mapa. “513 artículos son aún muy pocos datos para poder entrenar un algoritmo de aprendizaje profundo. Aunque para este proyecto en particular los algoritmos de machine learning suelen funcionar mejor que los de reglas, lograr ponerlos a punto y contar con los datos anotados necesarios para entrenarlos puede ser más costoso”, concluye Cotik.